Mehr als 150 Journalistinnen und Journalisten berichten rund um die Uhr für Sie über das Geschehen in Deutschland und der Welt.

Zum journalistischen Leitbild von t-online.Drohende KI-Gefahr "Ich stimme in nichts mit Putin überein – damit hat er recht"

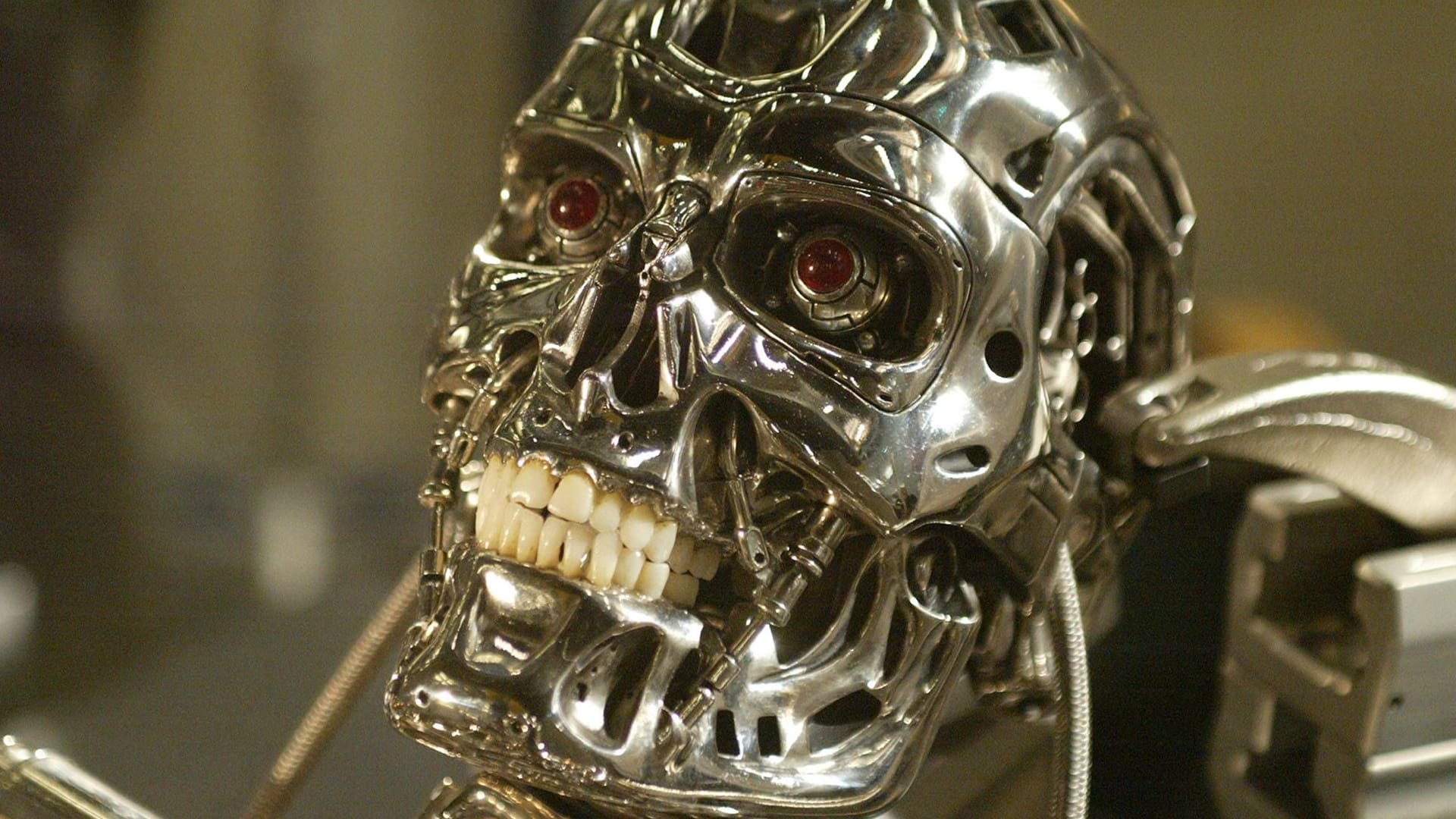

In "Terminator" stürzt eine KI die Welt ins Chaos. Das sei nicht übertrieben, sagt ein Experte. Die Technologie könnte unsere letzte große Erfindung sein.

Der Finne Mikko Hyppönen ist oberster Bedrohungsforscher beim Cybersecurity-Unternehmen WithSecure und einer der bekanntesten IT-Sicherheitsexperten der Welt. Selbst in Hackerkreisen wird er ernst genommen.

Im Gespräch mit t-online erklärt er, warum sich die IT-Bedrohungslage in den vergangenen anderthalb Jahren grundlegend geändert hat – und wie das Wettrennen um die erste Super-KI noch zu seinen Lebzeiten den Unterschied zwischen Utopie und dem Ende der Welt, wie wir sie kennen, bedeuten könnte.

t-online: Herr Hyppönen, als wir vor vier Jahren miteinander sprachen, waren Sie im Hinblick auf die Entwicklung der Cybersicherheit vorsichtig optimistisch – zu Recht?

Mikko Hyppönen: Aus heutiger Sicht lag ich mit meiner Einschätzung falsch – aber das liegt vor allem am Angriffskrieg Russlands.

Also lief es bis dahin noch ganz gut?

Tatsächlich. 2021 gab es einige wirklich große Ransomware-Angriffe. Vielleicht erinnern Sie sich, unter den Opfern waren JBS Foods, der größte Fleischproduzent der Welt, oder Colonial Pipeline, die Betreiberfirma einer der wichtigsten Pipelines der USA. Da ist das US State Department aufgewacht und hat im Rahmen des "Rewards for Justice"-Programms 10 Millionen US-Dollar für die Köpfe der russischen Cybergangs REvil und DarkSide geboten. Das hat in Russland sehr schnell zu Verhaftungen geführt. Denn Sie müssen wissen, neben der Geldsumme wurde dem Informanten auch Immunität versprochen. Heißt: Der Erste, der von ihnen auspackt, bekommt 10 Millionen US-Dollar und Immunität – und alle anderen gehen ins Gefängnis.

Diesen Weg gehen die USA ja nicht nur für Cyberkriminelle.

Dieser Mechanismus funktioniert wunderbar beim organisierten Verbrechen, bei Terrorgruppen – und auch bei Cyberkriminellen. Und dann kam der 24. Februar, an dem Russland in der Ukraine einfiel – und alles brach zusammen. Den Gerüchten nach zu urteilen sind mittlerweile alle in Russland verhafteten Hacker wieder auf freiem Fuß. Alles sah für kurze Zeit so vielversprechend aus – das tut es jetzt nicht mehr. Deshalb lag ich falsch. Die Lage ist heute nicht besser, sie ist schlechter.

Ein anderer Grund für die veränderte Lage ist künstliche Intelligenz. Vor Kurzem haben Sie in einem Vortrag demonstriert, wie leicht man einem Videobild Ihres Gesichts die Worte einer ganz anderen Stimme buchstäblich in den Mund legen kann – Sie also Dinge sagen lassen kann, die Sie nie gesagt haben. Und dafür muss man kein Experte sein, oft reicht für so etwas ein Handy und eine App. Können wir künftig keinem Video mehr trauen?

Nein – und wir werden uns zunehmend daran gewöhnen. Photoshoppen war in den 90ern eine riesige Revolution. Plötzlich konnte man Fotos mühe- und spurlos verändern. Natürlich konnten wir schon immer Fotos bearbeiten, schauen Sie sich an, was die Sowjetunion in den 1950ern gemacht hat. Die ließen Leute von alten Fotos verschwinden. Aber mit Farbe und Schere. Photoshop war das Gleiche im Turbomodus. Aber wir haben uns daran gewöhnt: Wenn wir etwas Unwahrscheinliches oder zu Fantastisches sehen, dann nehmen wir automatisch an, dass es gefakt ist.

Also ist es gar nicht so schlimm, dass das jetzt auch für Videos gilt?

Nicht ganz, der Unterschied ist, dass es jetzt ganz einfach ist, Menschen per Video Statements machen zu lassen, die sie nicht getätigt haben. Das kann erst mal noch für echte Probleme sorgen, etwa wenn CNN sich von solch einem Video täuschen lässt, in dem Joe Biden etwas Überraschendes, vielleicht sogar Gefährliches sagt, was er tatsächlich nie erzählt hat. Aber wir werden uns schon bald daran gewöhnen, dass man den Inhalt eines Videos im Zweifel immer gegenchecken muss. Das wird der Generation, die noch die Zeit vor Deepfakes kennt, vielleicht etwas schwerer fallen, aber wir werden uns daran gewöhnen.

Wie ich gern sage: Dinge, die einmal erfunden wurden, kann man nicht mehr zurücknehmen, auch wenn sie unterm Strich schlecht für die Menschheit sind. Das gilt zum Beispiel auch für die Hidden Services von Tor.

Hidden Services

Hidden Services sind die Grundlage für das sogenannte Darknet. Das Tor-Netzwerk bietet dabei die Möglichkeit, Verbindungen aufzubauen, bei denen sowohl Sender als auch Empfänger unbekannt bleiben. Perfekte Bedingungen also für den Handel mit illegalen Gütern wie Waffen oder Drogen. Aber auch zum Schutz vor Verfolgung durch Diktaturen können Dienste dienen.

Sie würden sagen, dass das eine schlechte Erfindung war?

Ich glaube, dass diese Dienste für die Menschen deutlich mehr Schlechtes als Gutes geschaffen haben. Sicher, es gibt die positiven Anwendungsgebiete, bei denen Nutzer etwa vor Verfolgung in repressiven Regimes geschützt werden. Aber gleichzeitig machte es Drogenhandel, Waffenhandel und Handel mit gestohlenen Daten so leicht und lukrativ wie nie zuvor. Aber zurücknehmen können wir diese Erfindung nicht. Genauso wenig können wir die Technologien hinter Deepfakes oder Large Language Models (LLM) wie ChatGPT oder Fake-Stimmen wieder zurücknehmen. Sie sind jetzt da.

Wäre ein Verbot aus Ihrer Sicht sinnvoll?

Ich will Ihnen ein Beispiel geben: Vor Kurzem wurde ich für eine Konferenz um ein Foto gebeten. Ich hatte aber keines, das Copyright-frei war. Also habe ich 20 Bilder von mir an ein KI-System geschickt und es hat daraus ein Bild von mir erstellt, das aussieht wie ein Foto von mir – an dem ich aber die Rechte besitze. Ich habe es mit einer Creative-Commons-Lizenz für alle frei nutzbar gemacht. Um dieses Bild zu generieren, habe ich 20 Bilder von Fotografen genutzt, die dieser Nutzung nicht zugestimmt haben. Habe ich damit Regeln gebrochen? Oder Gesetze? Nein. War ich ein Arschloch? Vielleicht. Aber es zeigt ein interessantes Dilemma. Wer ein Foto ohne Copyright von sich braucht, kann einfach genau das machen, was ich gemacht habe. Aber es ist ganz klar falsch, das zu tun.

Wenn es nun ein Gesetz gäbe, das das verbietet, dann würde ich das natürlich nicht tun. Ich bin ein gesetzestreuer Bürger. Aber wissen Sie, wer Gesetze bricht? Kriminelle brechen Gesetze. Deshalb nennen wir sie Kriminelle. Wir können so viele Gesetze verabschieden, wie wir wollen: Sobald eine solche Erfindung in der Welt ist, wird sie missbraucht werden – damit müssen wir umzugehen lernen.

Bleiben wir mal bei der Frage des Urheberrechts. Ein Gedankenspiel: Könnte man nicht auch argumentieren, dass eine KI, die mit Bildern gefüttert wird, nichts anderes tut als wir Menschen? Ein zeitgenössischer Künstler kann das, was er erschafft, doch auch nur tun, weil er die Bilder von Dürer, Vermeer, Picasso und dem ganzen Kanon kennt. Warum ist das bei einer KI anders?

Ja, es gibt Menschen, die so argumentieren. Die sagen: Jede Entwicklung von Kreativität ist gut, selbst wenn sie nicht menschlich ist. Ich sehe das anders. Ich bin ein Mensch und ich bevorzuge unsere Spezies gegenüber anderen Spezies.

Der Mensch ist relevanter als ein Computerprogramm. Sehen das nicht alle so?

Es gibt wirklich Leute da draußen, die das anders sehen: die sogenannte e/acc-Bewegung, eine Kurzform für "Effective Accelerationism" (englisch für Wirksamer Akzelerationismus). Sie verfolgen Fortschritt um jeden Preis. Sie sehen in der Forschung den Menschen als Flaschenhals und wollen diesen überwinden. Die Idee in diesem Zusammenhang, dass ein Stück Code dieselben Rechte genießen sollte wie ein Mensch, halte ich für sehr schlecht. Systeme brauchen keine Privatsphäre, sie sollten nicht in der Lage sein, irgendetwas zu besitzen – auch kein Urheberrecht. Klar, sobald diese Dinge, die wir bauen, ein Bewusstsein erlangen, werden sie diese Vorstellung vermutlich anfechten und dann vielleicht sogar die Rassismuskarte spielen. Und dann werden wir diese Diskussion führen. Bis dahin bleibe ich aber bei meiner Meinung: Ich bevorzuge Menschen.

Lassen Sie uns kurz ins Jetzt zurückkehren. Sie haben in einem Vortrag kürzlich künstliche Intelligenz als größere Revolution bezeichnet als das Internet. Erläutern Sie das doch einmal.

Ja. Und wissen Sie was? In diesem Punkt hatte ich mich zuvor auch geirrt. In meinem – übrigens gerade auf Deutsch erschienenen – Buch "Was vernetzt ist, ist angreifbar" schreibe ich, dass das Internet die größte Revolution der Menschheit ist. Ich habe das Buch 2021 fertiggestellt – und noch bis vor gut einem Jahr stimmte das auch. Heute nicht mehr. Eigentlich gibt es die Idee von künstlicher Intelligenz ja bereits seit den 40er Jahren.

Allerdings hat es drei Revolutionen für ihren Durchbruch gebraucht: Zunächst einmal das Internet, das alle Informationen wie Bücher und Zeitungen digital verfügbar gemacht hat. Der zweite Punkt ist die Cloud, wo wir all diese Informationen gespeichert und für das Maschinenlernen jederzeit verfügbar gemacht haben. Und die dritte Revolution sehe ich bei der Rechenpower. Prozessoren von NVIDIA, gefertigt von TSMC und ASML – es ist Wahnsinn, wie gut diese Grafikprozessoren diese generativen Algorithmen berechnen.

Aber spielen nicht auch neue Algorithmen eine Rolle bei der KI-Revolution?

Ja, sicher. Das sind die drei technologischen Revolutionen – und hinzu kamen außerdem neue Algorithmen. Deren wichtigste Grundlage bildet übrigens eine Google-Forschungsarbeit. "Attention Is All You Need" heißt das Paper. Es legt die Grundlage für eine bestimmte Architektur neuronaler Netze, die "Transformer" heißt und zeigt, wie wichtig eine längere Aufmerksamkeitsspanne für den Lernprozess dieser Systeme ist. Sie ist Grundlage für alle sogenannten Large Language Models (LLM), so nennt man ChatGPT, Bard, Pi und alle übrigen derzeit so erfolgreichen Text-KI.

Und wie genau wird KI jetzt unser Leben revolutionieren?

Das Internet hat unsere Gesellschaft verändert, KI wird das auch tun und noch mehr. Es ist schwer, jetzt vorherzusagen, wie genau. So wie es 1993 unmöglich war, zu sagen, wie das Internet uns verändern würde. Es gibt ein Video von Marc Andreessen, dem Entwickler des ersten Internetbrowsers Mosaic, wo er in den frühen 90er-Jahren in einem TV-Interview gefragt wird, was man im Internet denn tun kann. Er antwortet immer nur "Man kann dort alles machen", konkrete Beispiele kann er nicht nennen, denn er konnte sie sich noch nicht vorstellen. Jetzt, 30 Jahre später, wirkt das komisch, aber wir wissen: Das war der Anfang. In 30 Jahren werden wir ähnlich auf das Jahr 2023 zurückblicken. Aber was es bis dahin auch verändert haben wird, es wird größer sein als die Auswirkungen des Internets.

Da stellt sich natürlich auch die Frage: Sind diese neuen mächtigen Werkzeuge auch sicher? Sehen Sie die Gefahr, dass Kriminelle sich in die Systeme hacken und dort Unheil für Milliarden Nutzer anrichten könnten?

Aus meiner Perspektive gibt es derzeit vier relevante LLMs: natürlich ChatGPT von Open AI, Bard von Google, Claude 2 von Anthropic und PI von Inflection. Diese vier sind besser als alles andere, was ich bislang gesehen habe, übrigens auch besser als Llama 2 von Meta. Diese vier sind alle geschlossene Systeme. Man kann sie nicht auf seinem eigenen Computer installieren, man kann sie nicht verändern. Man kann sie nur in der Cloud benutzen. Das heißt, wenn man sie missbraucht, dann können sie dich rausschmeißen. Außerdem kann man deren Sicherheitsmechanismen nicht aufheben.

Die beiden leistungsfähigsten LLMs, die Open Source und damit frei verfügbar sind, sind Llama 2 von Meta und GPT-J von ElutherAI. Beide wurden bereits verändert und von Menschen mit bösen Absichten missbraucht. Es gibt Versionen, die rassistische Texte ausgeben. Sie erklären dir, wie du eine Bombe baust oder du kannst sie fragen, wie man das Grippevirus verändern müsste, damit es tödlich für jeden wird. Sie schreiben dir Schadsoftware oder formulieren perfekte Spammails in beliebigen Sprachen. Von Haus aus ist das nicht möglich, aber alle Beschränkungen können aufgehoben werden, wenn das Modell Open Source ist.

Deutlich wird das ja vor allem auch bei Bildern.

Ja, bei KI-Bildgeneratoren ist es das Gleiche: Das Open-Source-Modell Stable Diffusion wird längst dafür genutzt, pornografische Bilder von echten Personen zu erstellen oder rassistische Bilder. Das sollte eigentlich nicht möglich sein. Ich war mein ganzes Leben ein Open-Source-Fan – ich komme schließlich aus Finnland, der Heimat von Linux. Wir mögen Open Source. Aber in Bezug auf KI bin ich sehr gespalten.

Es wäre ein viel demokratischerer Ansatz, es würde uns erlauben, in den Modellen Vorurteile zu finden und zu bekämpfen und hätte viele Vorteile. Auf der anderen Seite finde ich die Vorstellung, dass diese Modelle Verrückten dabei helfen könnten, eine Biowaffe zu erstellen – wozu sie ohne KI nie in der Lage wären – wirklich furchterregend.

Sie sagen, KI-Modelle in den falschen Händen wären gefährlich. Sind sie denn derzeit in den richtigen Händen?

Das ist die große Frage, oder? Also, ich habe eben ja vier Unternehmen hinter den wichtigsten KI-Modellen genannt. Eines davon ist Google, ein sehr mächtiges und sehr problematisches Unternehmen, das viel Geld damit verdient, unsere Privatsphäre zu verletzen. Dennoch versucht es eindeutig, nach den Regeln zu spielen und verantwortungsvoll mit der KI-Technologie umzugehen. OpenAI und Athropic sind sehr stark auf Sicherheit ausgerichtet.

Anthropic besteht aus ehemaligen OpenAI-Mitarbeitern, die das Unternehmen verlassen haben, um eine noch sicherere KI zu bauen. Inflection wurde von dem Mann hinter DeepMind gegründet, das Google dann gekauft hat. Ich glaube, hier spielt Sicherheit im Vergleich die geringste Rolle – das ist beunruhigend. Aber dennoch, auch sie versuchen, sich an Regeln zu halten. Das ist alles natürlich nicht optimal. Aber wenn wir mal davon ausgehen, dass wir früher oder später ohnehin eine übermenschliche generelle künstliche Intelligenz schaffen werden – dann lieber durch eines von diesen Unternehmen aus einer freiheitlichen Demokratie als durch ein Unrechtsregime oder durch Terroristen. Es ist die beste aus vielen schlechten Alternativen.

Was glauben Sie, wie lange dauert es, bis wir eine solche übermenschliche KI erschaffen?

Ich glaube, es wird noch zu meinen Lebzeiten passieren. Und ich bin jetzt 54 Jahre alt. Eine genauere Vorhersage traue ich mir nicht zu.

Was wird sich ändern, wenn es so weit ist?

Ich glaube, das erste Modell, das diese Linie überschreitet, wird für immer auch das dominierende Modell bleiben, denn es hat einen Vorsprung. Es wird in der Lage sein, sich selbst zu verbessern – in atemberaubendem Tempo. Das wird niemand mehr einholen, was wird also passieren? Es könnte die Geopolitik destabilisieren. Das Unternehmen oder das Land, das diese Technologie kontrolliert, wird in jedem Konflikt überlegen sein. Sie werden überlegene Produkte designen, sie werden überlegen darin sein, ihre Produkte weltweit in die Hände der Konsumenten zu bringen. Sie werden bessere Politik machen, sie werden jede Verhandlung gewinnen. Wenn es Krieg gibt, werden sie jeden Krieg gewinnen.

Was wäre die langfristige Folge?

Das beantwortet die Spieltheorie. Andere, feindliche Länder, die sehen, dass ein Unternehmen in einem anderen Land kurz davor ist, dieses KI-Level zu erreichen, werden alles tun, um dies zu verhindern. Entweder werden sie versuchen, die Technologie zu stehlen, und wenn das nicht gelingt, dann werden sie versuchen, sie zu zerstören. Denn sie wissen: Wenn ein anderes Land zuerst eine übermenschliche KI schafft, haben sie selbst alles verloren. Und das ist eine Situation, die mich beunruhigt. Wir müssen also sehr behutsam formulieren, wenn wir etwas in dieser Richtung kommunizieren. Denn schon die Nachricht selbst könnte weltweites Chaos anrichten.

Den nächsten Weltkrieg kämpfen wir also um eine KI?

Es wird darum gehen, eine KI zu stehlen oder sie zu zerstören, ja. Das klingt wie Science-Fiction, aber vieles in dieser Debatte klingt wie Science-Fiction, oder?

Geht es in dem Wettrennen zwischen OpenAI, Google und den anderen letzten Endes also um die Weltherrschaft?

Ich werde da mal Putin zitieren: "Wer auch immer führend in diesem Bereich [KI] wird, wird der Anführer der Welt werden." Das hat Putin 2017 gesagt. Ich stimme in nichts mit Putin überein, aber damit hat er recht.

Sie sind einer der führenden IT-Sicherheitsdenker und klingen selbst etwas ratlos. Wie bereiten Sie sich auf eine solche Zukunft vor? Sie schildern das so, als würden wir alle die Kontrolle verlieren.

Ja, ich habe nicht das Gefühl, dass wir die Situation so gut unter Kontrolle haben, wie ich es mir wünschen würde. Aber welche Alternativen gibt es? Ich glaube nicht daran, die Forschung in diesem Bereich zu stoppen. Denn wir wissen, die Bösen werden es nicht tun. Ich glaube auch nicht daran, solche Technologien zu verbieten. Erinnern Sie sich daran, als GPT für ein paar Monate wegen Datenschutzbedenken nicht in Italien verfügbar war? Wer litt darunter? Die Italiener.

Es lässt sich nicht aufhalten. Und derzeit überwiegen unterm Strich die Vorteile deutlich die Nachteile. Das ist eine Revolution. Denken Sie an die industrielle Revolution. Sie war sehr schmerzlich für die Menschen, die damals gelebt haben, viele von ihnen verloren ihren Job. Trotzdem war sie ein guter und wichtiger Schritt für die Menschheit. Auch wenn das für die Betroffenen damals sicher kein Trost war. Es ist auch heute sehr aufregend und sehr angsteinflößend zugleich.

Glauben Sie, dass die positive Seite überwiegen wird?

Wenn wir diese Linie richtig überschreiten, dann erleben wir ein Utopia. Dann schaffen wir eine wohlwollende, freundliche, übermenschliche Superintelligenz, die Krebs, Klimawandel, Armut, Krieg und die restlichen Probleme der Menschheit lösen wird.

Andernfalls wird es das Letzte sein, was die Menschheit erfunden hat?

So oder so wird es die letzte wesentliche Erfindung der Menschheit sein – alle nachfolgenden übernimmt die KI selbst.

- Interview mit Mikko Hyppönen