Unterstützungsfunktionen iPhone kann bald mit der Stimme des Nutzers sprechen

Apple hat neue Unterstützungsfunktionen für Nutzer mit Behinderung vorgestellt. Viele davon sind beeindruckend.

Apple will seine iPhones und iPads in den kommenden Monaten mit weiteren Funktionen ausstatten, die die Bedienung für Menschen mit körperlichen und kognitiven Einschränkungen erleichtern. Das hat das Unternehmen mitgeteilt.

Auch andere große Tech-Unternehmen bemühen sich seit Jahren, ihre Geräte für Menschen mit körperlichen Einschränkungen möglichst gut nutzbar zu machen. Apple geht hier aber seit Jahren mit gutem Beispiel voran – wie viel Know-How in diesen Barrierefreiheitsfunktionen steckt, zeigen die Neuerungen, die das Unternehmen für die kommenden Monate angekündigt hat.

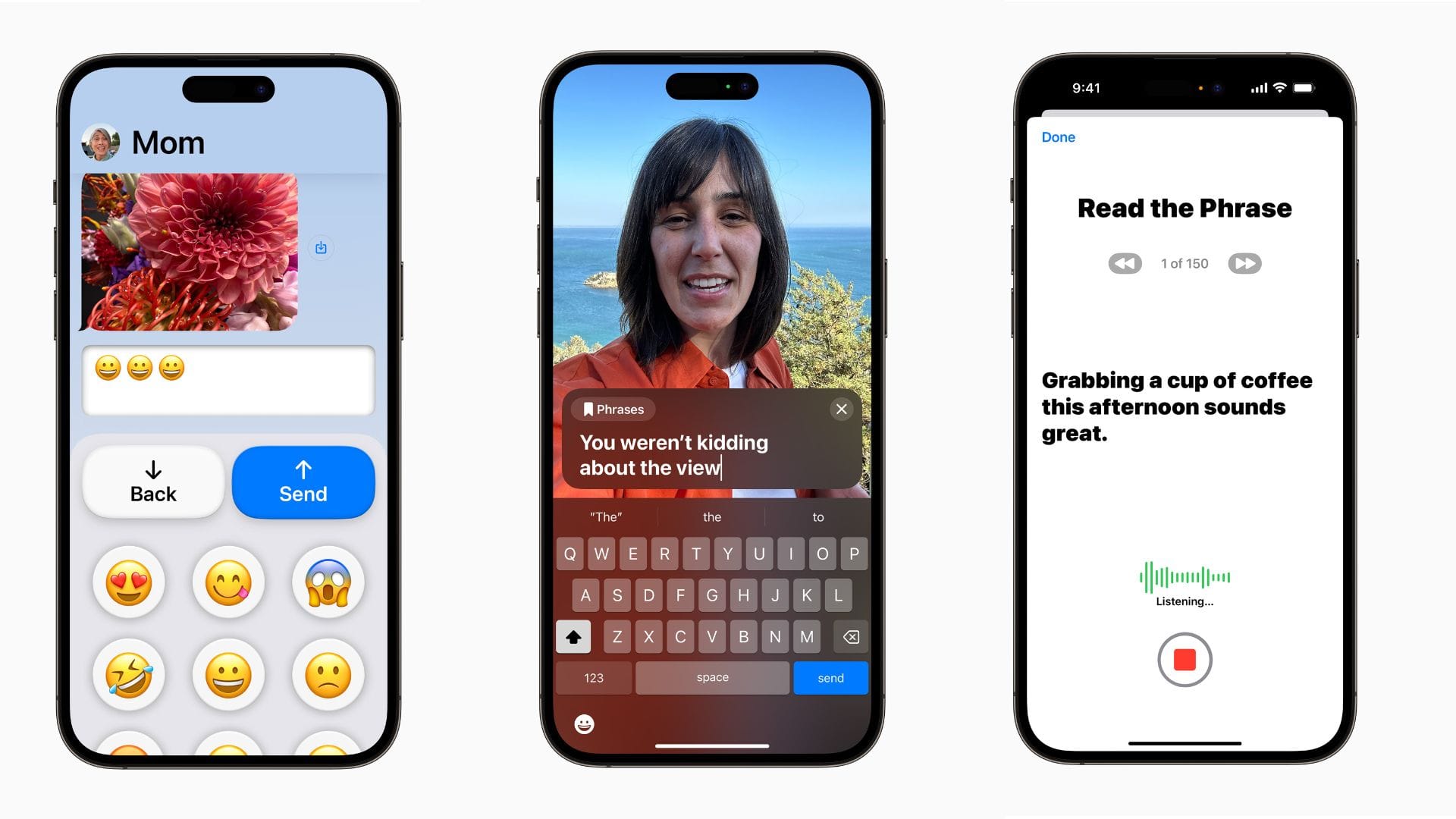

Erstmals wird Apple auch ein Angebot für Menschen mit kognitiven Einschränkungen bieten: Assistive Access. Diese Funktion bietet ein stark vereinfachtes Layout, bei dem man sich nur auf die wichtigsten Funktionen beschränkt – Musik, Telefon, Nachrichten, Fotos und die Kamera. Apps von Drittherstellern wie etwa YouTube oder Candy Crush können außerdem hinzugefügt werden.

Die Apps selbst sind ebenfalls sehr einfach und gut bedienbar gestaltet, in der Nachrichtenapp kann entweder via Text, großen Emojis oder kleinen Selfie-Videos kommuniziert werden.

Sprachunterstützung auf den Geräten

Sehr hilfreich für Menschen mit Sprachbeeinträchtigungen dürften außerdem Live Speech und Personal Voice sein. Live Speech übersetzt eingegebenen Text in natürlich gesprochene Sprache.

Die Funktion ist direkt in die Telefon-App oder in Face-Time eingebaut, so dass auch ein Audiotelefonat auf diese Weise möglich ist, selbst wenn die telefonierende Person nicht sprechen kann. Oft gebrauchte Phrasen und Sätze lassen sich speichern, um sie bei Bedarf sofort äußern zu können.

Menschen, bei denen die Gefahr besteht, dass sie ihre Stimme verlieren werden, können bald ihr iPhone auf den Klang der eigenen Stimme trainieren. Die Funktion heißt Personal Voice und erfordert, dass Nutzer etwa eine Viertelstunde lang vorgegebene Sätze ins iPhone sprechen.

Anschließend erklingt die Sprachausgabe von Live Speech mit dem eigenen Stimmklang. Eine Demo der Funktion, die wir uns anhören konnten, klang bereits recht gut – auch wenn noch klar hörbar war, dass es sich um eine künstlich generierte Stimme handelte – zum Täuschen biometrischer Sicherheitsfunktionen taugt das sicher nicht.

Der Sound der eigenen Stimme bleibt übrigens auf dem Gerät, auf dem man es trainiert hat und landet auf keinem Apple-Server. Erst wenn man aktiv zustimmt, kann er via iCloud auf andere Geräte des Apple-Kontos übertragen werden.

Spannende Hilfe für Menschen mit Sehbeeinträchtigung

Außerdem bringt Apple seinem mobilen Betriebssystem iOS eine enorm hilfreiche Funktion für Menschen mit fehlender oder stark eingeschränkter Sehfähigkeit bei: Detection Mode. Dabei handelt es sich um eine Erweiterung der App Lupe.

Die ist schon heute in iOS eingebaut und bietet Nutzern allerlei Möglichkeiten, ihre Umwelt zu vergrößern oder mit höherem Kontrast oder bestimmten Farbfiltern anzuzeigen. Point and Speak soll nun eine der großen Alltagsherausforderungen für Menschen mit Sehbehinderung entschärfen: Bedienfelder von Geräten ohne fühlbare Tasten.

Touchdisplays aller Art sind für blinde Menschen ohne Hilfe nämlich nicht – oder nur sehr schlecht – zu bedienen: Können sie sich bei fühlbaren Schaltern die Position der einzelnen Funktionen und Tasten merken, ist ein Touchdisplay nur eine große undefinierte glatte Fläche.

Point and Speak funktioniert folgendermaßen: Der Nutzer stellt sich vor ein Bedienfeld wie etwas das einer Mikrowelle mit Touchdisplay, startet Point and Speak und richtet das iPhone mit einer Hand so aus, dass die Kamera auf das Bedienfeld zeigt. Mit der anderen Hand führt der Nutzer nun den Finger über das Bedienfeld und über eine mutmaßliche Schaltfläche.

Das iPhone erkennt nun, über welcher Schaltfläche sich der Finger befindet und liest dann laut die zugehörige Beschriftung vor. Bewegt der Nutzer den Finger weiter und hält wieder an, liest das iPhone dann dort die Beschriftung vor. Auf diese Weise soll die Bedienung auch ganz ohne Sehvermögen funktionieren.

Bislang gibt es nur ein Video von der Funktion. Wie gut sie im Alltag funktioniert, muss dann im Verlauf des Jahres geprüft werden. Klappen wird dies übrigens nur mit iPhone Pro 12, Pro 13 und Pro 14, da es für die Erkennung laut Apples Beschreibung auch den LiDAR-Scanner nutzt, der nur in diesen Geräten verbaut ist.

Darüber hinaus hat Apple noch weitere kleinere Funktionen für Barrierefreiheit angekündigt. Wann genau sie ausgeliefert werden, ist nicht bekannt. Denkbar wäre etwa zusammen mit der neuen iOS-Version im Herbst.

Alle Informationen zu Apples Barrierefrfeiheitsfunktionen findet man außerdem unter apple.com/de/accessibility auf Apples Website.

- Apple Pressemitteilung / Apple Briefing